Künstliche Intelligenz

Grundlagen und Herausforderungen

Beitrag von Univ.-Prof. em. Dr. Klaus Mainzer

Dieser Beitrag führt in eine der faszinierendsten Forschungsentwicklungen der Gegenwart ein, die unsere Zukunft revolutionieren wird. Unter Künstlicher Intelligenz (KI) werden gegenwärtig vor allem die Algorithmen des Machine Learning verstanden - doch wie umfassend erobert KI unseren Alltag? Erfahren Sie mehr über den Einsatz von KI, neuronale Netze, selbstlernende Fahrzeuge und den Stellenwert der KI im Zeitalter von IoT und Industrie 4.0.

KI im Alltag

Künstliche Intelligenz (KI) beherrscht längst unser Leben, ohne dass es vielen bewusst ist. Smartphones, die mit uns sprechen, Armbanduhren, die unsere Gesundheitsdaten aufzeichnen, Arbeitsabläufe, die sich automatisch organisieren, Autos, Flugzeuge und Drohnen, die sich selbst steuern, Verkehrs- und Energiesysteme mit autonomer Logistik oder Roboter, die ferne Planeten erkunden, sind technische Beispiele einer vernetzten Welt intelligenter Systeme. Sie zeigen uns, wie unser Alltag von KI-Funktionen bestimmt ist.

Was ist künstliche Intelligenz?

Alan M. Turing definierte 1950 in dem nach ihm benannten Test ein System dann als intelligent, wenn es in seinen Antworten und Reaktionen nicht von einem Menschen zu unterscheiden ist. Der Nachteil dieser Definition ist, dass der Mensch zum Maßstab gemacht wird.

Auch biologische Organismen sind nämlich Beispiele von intelligenten Systemen, die wie der Mensch in der Evolution entstanden und mehr oder weniger selbstständig Probleme effizient lösen können. Daher nenne ich (in einer vorläufigen Arbeitsdefinition) ein System dann intelligent, wenn es selbstständig und effizient Probleme lösen kann [1] (S. 3). Der Grad der Intelligenz hängt vom Grad der Selbstständigkeit des Systems, dem Grad der Komplexität des Problems und dem Grad der Effizienz des Problemlösungsverfahrens ab.

Expertensysteme

Mitte der 70er bis Mitte der 80er Jahre rückten wissensbasierte Expertensysteme in den Vordergrund, die erste praktische Anwendungen versprachen. Abgegrenztes und überschaubares Spezialwissen menschlicher Experten, wie z.B. von Ingenieuren und Ärzten sollte für den tagtäglichen Gebrauch zur Verfügung gestellt werden.

Bei wissensbasierten Expertensystemen handelt es sich um KI-Programme, die Wissen über ein spezielles Gebiet speichern und aus dem Wissen automatisch Schlussfolgerungen ziehen, um konkrete Lösungen zu finden oder Diagnosen von Situationen bereitzustellen. Im Unterschied zum menschlichen Experten ist das Wissen eines Expertensystems aber auf eine spezialisierte Informationsbasis beschränkt, ohne allgemeines und strukturiertes Hintergrundwissen über die Welt.

Um ein Expertensystem zu bauen, muss das Wissen des Experten in Regeln gefasst, in eine Programmsprache übersetzt und mit einer Problemlösungsstrategie bearbeitet werden. Menschliches Können lässt sich aber nur begrenzt in formalen Regeln festhalten. Beispiele zeigen sich, wenn wir Menschen z.B. den Aufschlag beim Tennis oder Abschlag beim Golf lernen.

Neuronale Netze und Machine Learning

Ein Gegenentwurf zu programmierten Computern sind die sich selbst organisierenden Gehirne lebender Organismen. Machine Learning mit neuronalen Netzen orientiert sich daher mit geeigneten Netzwerk-Topologien und Lernalgorithmen an der Informationsverarbeitung von Gehirnen: Neuronen (Nervenzellen) sind untereinander durch Synapsen verbunden, durch die neurochemische Signale wandern. Im grafischen Modell werden Neuronen durch Knoten und Synapsen durch Kanten verbunden. Kanten sind durch Zahlen gewichtet, mit denen die Intensität der neurochemischen Verbindung durch Synapsen angezeigt wird.

Lernen bedeutet auf der neuronalen Ebene, dass erregte Neuronen sich in Verschaltungsmustern verschalten. In der Neuropsychologie kommt hinzu, dass solche Verschaltungsmuster mit kognitiven Zuständen wie Wahrnehmungen, Vorstellungen, Gefühlen, Denken und Bewusstsein verbunden sind. Im Modell neuronaler Netze werden diese Verschaltungsvorgänge durch Lernalgorithmen modelliert, mit denen die synaptischen Zahlengewichte verändert werden, da sie für die Intensität der jeweiligen neuromischen Stärke der synaptischen Verbindungen in einem Verschaltungsmuster stehen.

Lernalgorithmen

Ähnlich wie in der Psychologie werden verschiedenen Arten von Lernalgorithmen unterschieden.

Beim überwachten Lernen wird dem neuronalen Netz zunächst ein Prototyp beigebracht. Das könnte z.B. das Verteilungsmuster der Pixel eines Gesichts sein. Die lokalen Stärken von Färbungen und Schattierungen werden durch entsprechende synaptische Zahlengewichte dargestellt. Man spricht auch vom Trainieren eines neuronalen Netzes, um die Zahlengewichte passend einzustellen. Durch Abgleich mit einem eintrainierten Prototyp kann z.B. ein Gesicht unter einer Vielzahl von Gesichtern wiedererkannt werden.

Beim nicht-überwachten Lernen ist das neuronale Netz in der Lage, selbstständig Ähnlichkeiten von Daten zu erkennen, um sie entsprechend zu klassifizieren. So kommt es, dass solche neuronalen Netze mit ihren Algorithmen das Gesicht z.B. einer Katze erkennen können, ohne vorher beigebracht bekommen zu haben, was eine Katze überhaupt ist.

Beim verstärkenden Lernen (Reinforcement Learning) wird dem System zunächst eine Aufgabe beigebracht, die es dann mehr oder weniger selbstständig lösen soll. Es könnte sich z.B. um einen Roboter handeln, der selbstständig einen Weg zu einem vorgegebenen Ziel finden soll. Beim Lösen dieser Aufgabe bekommt der Roboter ständig in bestimmten Zeitintervallen Rückmeldungen (Rewards), wie gut oder wie schlecht er dabei ist, den Weg bzw. die Aufgabenlösung zu finden. Die Lösungsstrategie besteht darin, diese Folge von Rückmeldungen zu optimieren. Deep Learning bezieht sich einfach auf die Tiefe des neuronalen Netzes, die der Anzahl der neuronalen Schichten entspricht. Bei einem Wahrnehmungsvorgang werden auf der ersten neuronalen Schicht nur farbige Pixel unterschieden, die auf der nächsten Schicht zu Ecken und Kanten verbunden werden, um auf der dritten Schicht in Teilen von Gesichtern eingefügt zu werden. Auf der vierten Schicht werden schließlich ganze Gesichter wiedergegeben.

Was im mathematischen Modell schon seit den 1980er Jahren bekannt war, wird erst seit wenigen Jahren technisch realisierbar, da nun die notwendige Rechenpower vorliegt (z.B. Google Brain mit 1 Million Neuronen und 1 Milliarde Synapsen).

Machine Learning und selbstlernende Fahrzeuge

Ein hochaktuelles Anwendungsbeispiel sind selbstlernende Fahrzeuge: So kann ein einfaches Automobil mit verschiedenen Sensoren (z.B. Nachbarschaft, Licht, Kollision) und motorischer Ausstattung bereits komplexes Verhalten durch ein sich selbst organisierendes neuronales Netzwerk erzeugen. Werden benachbarte Sensoren bei einer Kollision mit einem äußeren Gegenstand erregt, dann auch die mit den Sensoren verbundenen Neuronen eines entsprechenden neuronalen Netzes. So entsteht im neuronalen Netz ein Verschaltungsmuster, das den äußeren Gegenstand repräsentiert.

Wenn wir uns nun noch vorstellen, dass dieses Automobil mit einem „Gedächtnis“ (Datenbank) ausgestattet wird, mit dem es sich solche gefährlichen Kollisionen merken kann, um sie in Zukunft zu vermeiden, dann ahnt man, wie die Automobilindustrie in Zukunft unterwegs sein wird, um selbstlernende Fahrzeuge zu bauen. Es wird sich um ein neuronales Lernen handeln, wie wir es in der Natur von höher entwickelten Organismen kennen.

Herausforderungen bei der Entwicklung autonomer Fahrzeuge

Wie viele reale Unfälle sind aber erforderlich, um selbstlernende („autonome”) Fahrzeuge zu trainieren? Wer ist verantwortlich, wenn autonome Fahrzeuge in Unfälle verwickelt sind? Welche ethischen und rechtlichen Herausforderungen stellen sich?

Bei komplexen Systemen wie neuronalen Netzen mit z.B. Millionen von Elementen und Milliarden von synaptischen Verbindungen erlauben zwar die Gesetze der statistischen Physik, globale Aussagen über Trend- und Konvergenzverhalten des gesamten Systems zu machen. Die Zahl der empirischen Parameter der einzelnen Elemente ist jedoch unter Umständen so groß, dass keine lokalen Ursachen ausgemacht werden können. Das neuronale Netz bleibt für uns eine „Black Box“. Vom ingenieurwissenschaftlichen Standpunkt aus sprechen Autoren daher von einem „dunklen Geheimnis“ im Zentrum der KI des Machine Learning [3].

Fazit zu Machine Learning

Zusammengefasst folgt: Machine Learning mit neuronalen Netzen funktioniert, aber wir können die Abläufe in den neuronalen Netzen (noch) nicht im Einzelnen verstehen und kontrollieren. Machine Learning Techniken sind ähnlich wie (statistische) Testvorgänge, aber das reicht für sicherheitskritische Systeme nicht aus und kann gefährlich werden – eine große Herausforderung der KI für die Zukunft!

Künstliche Intelligenz und Entscheidungen mit unvollständiger Information

In komplexen Märkten verhalten sich Menschen nicht nach den axiomatisch festgelegten rationalen Erwartungen eines „repräsentativen Agenten“ (homo oeconomicus), sondern entscheiden und handeln mit unvollständigem Wissen, Emotionen und Reaktionen (z.B. Herdenverhalten).

Nachdem vor mehr als zwanzig Jahren 1997 der Supercomputer Deep Blue von IBM den amtierenden Schachweltmeister geschlagen hatte, kam 2016 Google mit der Software AlphaGo, um die Champions im asiatischen Brettspiel Go zu schlagen. Noch spektakulärer ist aber eine jüngst vorgestellte Software, die menschliche Champions in Poker schlug. Im Unterschied zu Brettspielen wie Schach und Go ist nämlich Poker ein Beispiel für Entscheidungen unter unvollständiger Information.

Von genau dieser Art sind Alltagsentscheidungen, die unter unvollständigen Information bei z.B. Verhandlungen zwischen Unternehmen, Rechtsfällen, militärischen Entscheidungen, medizinischer Planung, Cybersecurity u.a. stattfinden.

Bei Poker werden immer Emotionen und Gefühle im Spiel vermutet, um den Gegner z.B. mit Pokerface aufgrund unvollständiger Information zu täuschen.

KI als Problemlöser

Bis aber Maschinen in der Lage sein werden, menschliche Emotionen zu verstehen oder gar zu realisieren, würden – so dachten selbst KI-Experten – noch viele Jahre vergehen, wenn es überhaupt gelingen sollte. Tatsächlich umschifft PokerCelebratus das Problem der Emotionen und schlägt Menschen durch schiere Computerpower plus raffinierter Mathematik.

An dieser Stelle wird schlagartig klar, dass erfolgreiche KI vor allem eine Ingenieurwissenschaft ist, die effizient Probleme lösen will. Es geht nicht darum, menschliche Intelligenz zu modellieren, simulieren oder gar zu ersetzen. Solange Menschen versuchten, den Flügelschlag der Vögel nachzuahmen, landeten sie auf der Nase. Erst als sich Ingenieure auf die Grundgesetze der Aerodynamik besannen, fanden sie Lösungen, wie sich tonnenschwere Fluggeräte in Höhen jenseits der Wolken bewegen lassen – Lösungen, die in der Evolution von der Natur nicht gefunden wurden.

Grafische Darstellung

Grafisch wird ein Spielverlauf durch einen Spielbaum dargestellt. Eine Spielsituation entspricht einem Astknoten, aus dem sich nach den Spielregeln endlich viele Spielzüge ergeben, die durch entsprechende Äste im Spielbaum dargestellt werden. Diese Äste enden wieder mit Astknoten (Spielsituationen), aus denen wieder neue mögliche Äste (Spielzüge) entspringen. So entfaltet sich ein komplexer Spielbaum.

In einem ersten Ansatz sucht ein effektives Verfahren die Schwächen eines vergangenen Spiels im entsprechenden Spielbaum heraus und versucht, sie in nachfolgenden Spielen (Spielbäumen) zu minimieren. Dabei spielt das System nicht zehn-, hundert- oder tausendmal gegen sich, sondern millionenfach aufgrund der enormen Rechenleistung eines Supercomputers. Bei ca. 10126 Spielsituationen im Pokerspiel würden das aber selbst die schnellsten Supercomputer in keiner realistischen Zeit schaffen.

Nun kommt Mathematik zum Einsatz: Mit Theoremen der mathematischen Wahrscheinlichkeits- und Spieltheorie lässt sich beweisen, dass sich in bestimmten Spielsituationen keine Erfolgschancen für nachfolgende Spieläste ergeben. Sie können also vernachlässigt werden, um so Rechenzeit und Speicherplatz zu reduzieren. So erhalten wir Programme, die von heutigen Computern realisierbar sind.

Cyberphysical Systems und IoT

Intelligenz entsteht in der Interaktion mit einer entsprechenden Umwelt. Physiologisch hat sich der Mensch mit seinem Gehirn seit der Steinzeit kaum verändert. Wir werden erst zu Menschen des 21. Jahrhunderts durch unsere Interaktionsmöglichkeiten in dieser technischen Gesellschaft.

Cyberphysical Systems zielen auf die Implementierung von sozialem und situativem Wissen in KI-Systemen, um ihre Dienstleistungsaufgaben in dieser Welt im Umgang mit dem Menschen zu verbessern. Die Devise lautet daher: Cyberphysical Systems mit Verteilter Künstlicher Intelligenz statt isolierter Künstlicher Intelligenz einzelner Roboter oder Computer.

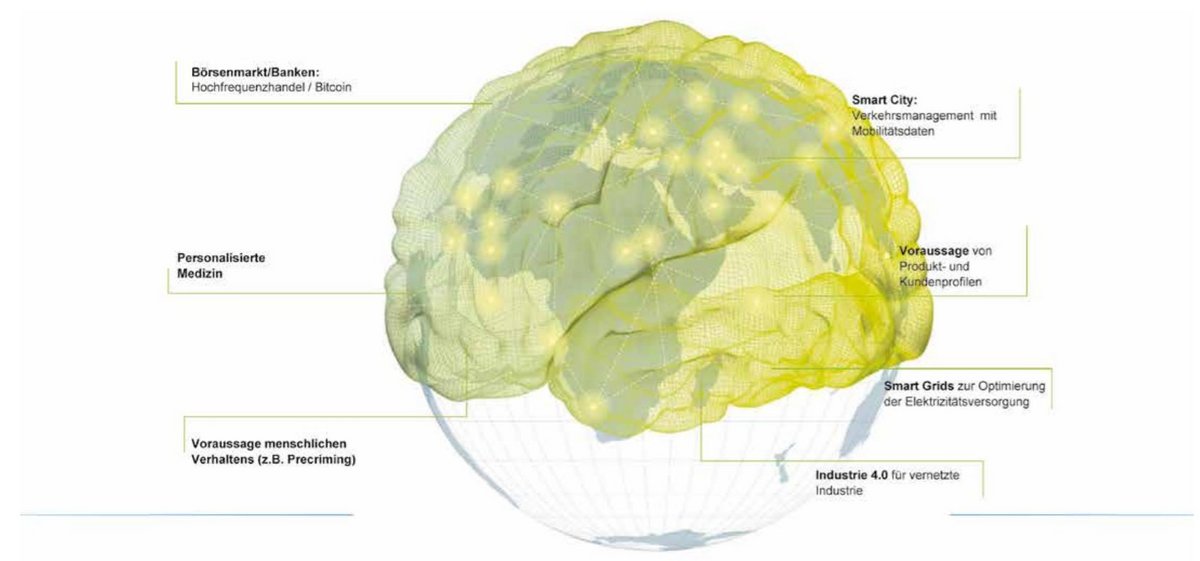

Ähnlich wie biologische Organismen mit ihren Milliarden von interagierenden Zellen, Organen, Sensoren und Nervensystemen lassen sich Gesellschaftssysteme als Superorganismen verstehen, die mit Waren- und Informationsströmen ausgestattet sind [1]. So steuern bereits lernfähige Algorithmen die Prozesse einer vernetzten Welt mit exponentiell wachsender Rechenkapazität. Ohne sie wäre die Datenflut im Internet nicht zu bewältigen, die durch Milliarden von Sensoren und vernetzten Geräten erzeugt wird. Nun kommunizieren also auch Dinge miteinander und nicht nur Menschen. Daher sprechen wir vom Internet der Dinge (Internet of Things: IoT).

Anwendung von IoT in der Industrie 4.0

Bei Industrie 4.0 wird das Internet der Dinge auf die Industrie- und Arbeitswelt angewendet. Industrie 1.0 war im 19. Jahrhundert das Zeitalter der Dampfmaschine. Zu Beginn des 20. Jahrhunderts war Industrie 2.0 durch die Einführung von Henry Fords Fließband bestimmt. Das Fließband ist nichts anderes als eine Algorithmisierung des Arbeitsprozesses, der Schritt für Schritt nach einem festen Programm durch arbeitsteiligen Einsatz von Menschen ein Produkt realisiert. In Industrie 3.0 greifen örtlich fixierte Industrieroboter in den Produktionsprozess ein und unterstützen seit Ende des 20. Jahrhunderts die Arbeit am Fließband.

In Industrie 4.0 werden Künstliche Intelligenz und Machine Learning in den Arbeitsprozess integriert. Werkstücke kommunizieren untereinander, mit Transporteinrichtungen und beteiligten Menschen, um den Arbeitsprozess flexibel zu organisieren. Produkte können so individuell zur gewünschten Zeit nach Kundenwünschen erstellt werden. Technik, Produktion und Markt verschmelzen zu einem soziotechnischen System, das sich selber flexibel organisiert und sich verändernden Bedingungen automatisch anpasst.

KI ist Dienstleister der Gesellschaft

Seit ihrer Entstehung ist die KI-Forschung mit großen Visionen über die Zukunft der Menschheit verbunden. Löst die „Künstliche Intelligenz“ den Menschen ab? Einige sprechen bereits von einer kommenden „Superintelligenz“, die Ängste und Hoffnungen auslöst.

Dieser Artikel ist demgegenüber ein Plädoyer für Technikgestaltung: KI muss sich als Dienstleistung in der Gesellschaft bewähren. Man muss aber ihre Grundlagen kennen, um ihre Leistungen und Grenzen abschätzen zu können [2].

Erstaunlicherweise, das halte ich für eine wesentliche philosophische Einsicht, ändern noch so schnelle Supercomputer nichts an den logisch-mathematischen Grundlagen, die von menschlicher Intelligenz bewiesen wurden. Erst auf der Grundlage dieses Wissens lassen sich auch gesellschaftliche Auswirkungen bewerten. Diese Chance menschlicher Intelligenz sollten wir nutzen!

Literatur

- Mainzer, Klaus (2016a): Künstliche Intelligenz. Wann übernehmen die Maschinen? Berlin: Springer Mainzer, Klaus (2016b): Information: Algorithmus – Wahrscheinlichkeit – Komplexität – Quantenwelt – Leben – Gehirn – Gesellschaft. Berlin: Berlin University Press

- Knight, W. (2017): The Dark Secret at the Heart of AI. In: MIT Technology Review. April 11: 1-22

Erstmals erschienen in: TiB Ausgabe 2018 Mai/Juni