KI in der optischen Qualitätssicherung

Anwendungspotenziale und Trends

Beitrag von Johannes Bauer, M. Sc. wissenschaftl. Mitarbeiter, Prof. Dr.-Ing. Rüdiger Daub Institutsleiter, Institut für Werkzeugmaschinen und Betriebswissenschaften (iwb)

Spätestens seit der Veröffentlichung der Software ChatGPT sind die weitreichenden Einsatzmöglichkeiten von Methoden der Künstlichen Intelligenz einer breiten Öffentlichkeit bewusst. Die Leistungsfähigkeit aktueller Verfahren beruht dabei wesentlich auf der Verfügbarkeit großer Datenmengen und Modelle, sogenannter tiefer neuronaler Netze. Letztere erzeugen Vorhersagen durch die Verarbeitung einer Eingabe via Millionen von linearen und nicht-linearen mathematischen Operationen mit den Modellparametern, die aus Trainingsdaten erlernt werden. Auch wenn aktuell v.a. generative Anwendungen, wie das automatisierte Erzeugen von Texten, diskutiert werden, liegen die Wurzeln der Verfahren in der maschinellen Bildverarbeitung. So zeigten die ersten tiefen Netzarchitekturen ihr enormes Potenzial bei der Klassifizierung von Bildern des populären ImageNet-Datensatzes.

Im Kontext der Produktionstechnik konnte das Potenzial tiefer neuronaler Netze in verschiedensten Bereichen aufgezeigt werden. Eine vielversprechende Anwendungsmöglichkeit stellen Aufgaben der optische Qualitätsüberwachung dar [1]. So können äußere Defekte, wie z.B. Unregelmäßigkeiten einer Schweißnaht, meist gut auf herkömmlichen Bildaufnahmen erkannt werden. Anhand der äußeren Erscheinungsbilder kann z.T. aber auch auf inneren Eigenschaften eines Werkstücks, wie den Schweißnahtquerschnitt, geschlossen werden [2]. Die automatisierte Überwachung solcher Qualitätsgrößen kann dazu beitragen, eine konstant hohe Produktqualität zu gewährleisten. Zudem können mangelhafte Zwischenprodukte frühzeitig erkannt und zur Überarbeitung ausgeschleust werden, sodass eine weitere Veredelung bereits defekter Produkte vermieden wird. Die Vorzüge tiefer neuronaler Netze gegenüber klassischen Bildverarbeitungsalgorithmen liegen v.a. in ihrer generischen Anwendung sowie erhöhten Robustheit. Die Modelle erfordern keine spezifische Vorverarbeitung der Bilddaten, sondern sie erlernen die Extraktion relevanter Merkmale auf Basis der Trainingsdaten. Dies führt dazu, dass sie generisch eingesetzt werden können. Auch vielfältig ausgeprägte Fehlerbilder oder Änderungen der Lichtverhältnisse können von den Verfahren gut bewältigt werden. Die Voraussetzung dafür ist jedoch, dass eine ausreichend große und umfassende Datenbasis für den Trainingsprozess zur Verfügung steht.

Im Folgenden wird zunächst eine Einführung in die Anwendung der Verfahren gegeben. Anschließend werden am iwb verfolgte Ansätze aufgezeigt, wie mit bestehenden Herausforderungen für die Verfahren, wie den hohen Anforderungen hinsichtlich der Datenverfügbarkeit, umgegangen werden kann.

Anwendung

Der Aufbau eines KI-basierten Qualitätsüberwachungssystems ähnelt stark dem eines klassischen industriellen Bildverarbeitungssystems. Neben einer Industriekamera inkl. Optik ist oft eine geeignete Beleuchtung notwendig, um Fehlerbilder auf den Aufnahmen hervorzuheben. Je nach Szenario kann sich eine gerichtete oder diffuse Beleuchtung als vorteilhaft erweisen. Die Verarbeitung der Bilder bzw. die Detektion von Fehlern durch das erlernte Modell kann, je nach Anforderungen an den zeitlichen Versatz der Vorhersage und die verfügbare Netzwerkbandbreite, dezentral an der „Edge“ oder zentral in der „Cloud“ erfolgen. Der Trainingsprozess zur Modellerstellung erfolgt üblicherweise „offline“ anhand eines vorab generierten Datensatzes. Erzielt das Modell eine zufriedenstellende Vorhersagegenauigkeit bei einem ausgewählten Testdatensatz, kann es in den realen Prozess integriert werden.

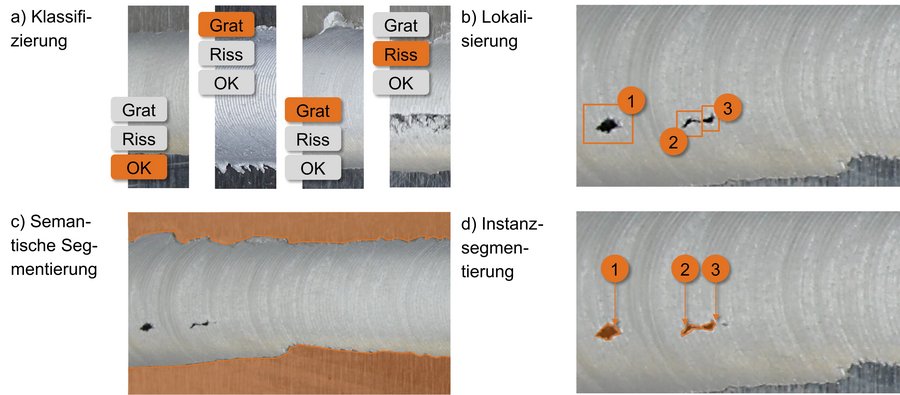

Je nach der Art der Ausgabe eines Modells lassen sich verschiedene Aufgaben umsetzen. Die bekanntesten Typen sind Klassifizierungs-, Lokalisierungs- und Segmentierungsaufgaben. Die Aufgabentypen werden in Abb. 1 visualisiert und im Folgenden anhand beispielhafter Anwendungen im Bereich des Rührreibschweißens erläutert.

Das Potenzial neuronaler Netze zur Qualitätsüberwachung von Rührreibschweißnähten konnte z.B. in [3] bestätigt werden. Verschiedene Modelltypen eignen sich, um Fehler, wie Gratbildung oder mangelnde Oberflächengüte, auf Farb- oder 3D-Aufnahmen der Nähte zu klassifizieren (vgl. Abb. 1 a). Auf größeren Blechen können relevante Bereiche über Methoden der Lokalisierung detektiert und eingegrenzt werden, wie in Abb. 1 b) ersichtlich. Beispiele einer semantischen Segmentierung bzw. einer Instanzsegmentierung zeigen Abb. 1 c) bzw. d). Während bei der semantischen Segmentierung Bereiche eines Bildes auf Pixelebene verschiedenen Klassen zugeordnet werden, wird bei der Instanz-Segmentierung zusätzlich zwischen versch. Instanzen derselben Klasse unterschieden. Mittels semantischer Segmentierung kann z.B. der Schweißnahtbereich vom Hintergrund separiert werden. Eine Instanzsegmentierung von Poren oder Rissen erlaubt neben der Bestimmung der Porenfläche auch die Ausgabe der konkreten Anzahl einzelner Poren.

Ausblick

Trotz der geschilderten, vielfältigen Potenziale bestehen weiter Herausforderungen beim Einsatz tiefer neuronaler Netze zur optischen Qualitätsüberwachung. Diese treten i.d.R. dann auf, wenn die verfügbare Trainingsdatenbasis keine ausreichend repräsentative Stichprobe der Grundgesamtheit darstellt oder sich die Verteilung der Daten – das optische Erscheinungsbild von Gut- oder Schlechtteilen – während des Einsatzes des Modells ändert. Derartige Änderungen können sich aufgrund geänderter Prozessparameter, Produkte oder Umgebungsbedingungen ergeben. Weichen die resultierenden optischen Erscheinungsbilder zu stark von denen der Trainingsdaten ab, kann dies die Performance eines Modells stark verschlechtern. Das Phänomen wird auch als Data oder Concept Drift bezeichnet [4].

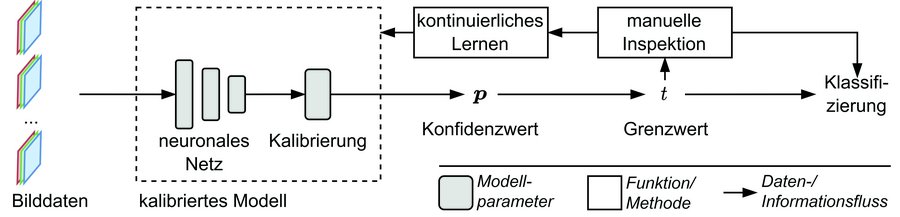

Im Kontext der variantenreichen Produktion müssen somit bei jeder Änderung neue Trainingsdaten generiert werden, was mit erheblichen Aufwänden verbunden ist. Ein am iwb verfolgter Ansatz, sieht daher die Adaption bereits bestehender, kalibrierter Modelle an solche geänderten Verhältnisse während des Einsatzes vor und wird in Abb. 2 visualisiert [5]. Durch die Anwendung sogenannter Kalibrierverfahren können vom Modell ausgegebene Konfidenzwerte für einzelne Vorhersagen an die langfristige Vorhersagegenauigkeit angeglichen werden. Somit können Vorhersagen mit niedriger Konfidenz, und damit einer hohen Wahrscheinlichkeit falsch zu sein, automatisiert identifiziert und die entsprechenden Werkstücke bzw. Produkte manuell inspiziert werden. Anschließend kann das Modell auf Basis der Ergebnisse der manuellen Inspektion, mittels sogenannter kontinuierlicher Lernverfahren, weiter verbessert werden. Dadurch, dass dabei auf bestehendem „Wissen“ im Modell aufgebaut werden kann, soll die benötigte Datenmenge und damit der Trainingsaufwand reduziert werden. Somit können KI-Methoden zur Verbesserung der variantenreichen Produktion beitragen.

Literatur

[1] Wang J, Ma Y, Zhang L, Gao RX, Wu D. Deep Learning for Smart Manufacturing: Methods and Applications. Journal of Manufacturing Systems 2018;48:144– 56.

[2] Mayr A, Bauer J, Franke J. A Multi-View Deep Learning Approach for Quality Assessment in Laser Welding of Hairpin Windings Based on 2D Image Captures. Procedia CIRP 2022;115:196–201.

[3] Hartl R, Landgraf J, Spahl J, Bachmann A, Zaeh MF. Automated Visual Inspection of Friction Stir Welds: A Deep Learning Approach. In: Multimodal Sensing Technologies and Applications; 2019, p. 52–75.

[4] Lu J, Liu A, Dong F, Gu F, Gama J, Zhang G. Learning under Concept Drift: A Review. IEEE Trans. Knowl. Data Eng. 2018;31(12):1–18.

[5] Bauer JC, Daub R. Continuous Adaptation of Deep Learning Models for Optical Quality Monitoring Tasks. In: IEEE, editor. 28th International Conference on Emerging Technologies and Factory Automation (ETFA); 2023.

Erstmals erschienen in: TiB Ausgabe 02/2024 MÄR/APR